AI就绪设计通常包括更高的功率密度、先进的冷却技术(如液冷),并针对GPU和AI工作负载进行优化,以实现更高的性能和能效。

日期:2024-11-09 10:22:34

10月30日消息,KKR和私募股权投资公司Energy Capital Partners(ECP)将投资500亿美元全面支持人工智能发展,主要方向为数据中心和能源领域。

10月30日消息,万国数据国际业务再获10亿美元股权融资,助力加速海外新兴市场战略布局。

10月30日消息,西贡电信技术股份公司(Saigontel)有意在胡志明市古芝县新富忠工业园(Tan Phu Trung)开发新的数据中心项目。

10月28日消息,微软计划在利金县开发三个数据中心园区,并在初始阶段投资10亿美元。该项目于周一获得了州税收优惠的批准。

10月28日消息,银川中创普惠智算中心项目12月初将完成设备调试,最快年底完成交付。

10月28日消息,中国(新疆)自贸试验区喀什片区智算中心预计11月中旬完成一期机房改造,最快年底将够提供算力服务。

10月25日消息,中贝合肥智算中心与知鱼智联正式签署算力集群交接书,完成首批华为910B算力集群交付。

10月24日消息,河南空港智算中心项目首批2000P算力正式进入加电调试阶段。

10月24日,尚航科技重磅发布尚航全新智算中心项目——“怀来尚云智算中心”。

……

10月8日,富士康宣布,将携手英伟达(NVIDIA),打造有史以来全球最快的单体AI超级计算中心——鸿海高雄超级计算中心。

……

10月以来,全球数据中心建设布局热度不减,尤其我国大批智算中心建设正全面提速,很多项目都陆续进入交付阶段。然而,随着生成式AI应用的持续发展,在进行智算中心规划和建设时,很多重要新变化值得引起行业关注,涉及智算中心的设施工程、电力、制冷等诸多厂商。

全球数据中心建设布局

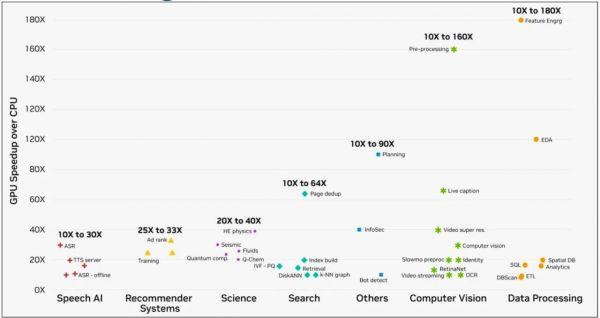

其中,两个重大变化值得整个IDC产业关注:一个是算力密度增加带来的设计、设备等一系列要求变化,主要涉及包括GPU的利用率以及总拥有成本TCO等问题。一个是电力需求引发的整体布局、设计、设备的要求变化,主要涉及包括工作负载以及故障等问题。

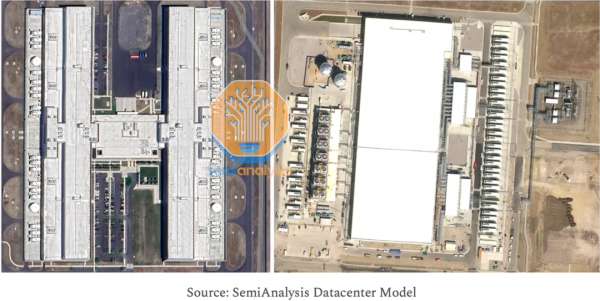

01 Meta拆了在建的数据中心

2022年12月,Meta对外宣布已经停建了两个位于丹麦欧登塞的数据中心,Meta这一动作的主要原因是旧设计(下图左侧)是针对低功率密度(Power Density)的方案,无法满足AI的全新需求,之后Meta用全新AI就绪设计(AI-Ready design)(下图右侧)替代了原有方案,这一举措对全球数据中心行业引发着深远影响。

AI就绪设计

【IDC圈注】“AI就绪设计(AI-Ready design)”指的是为应对人工智能应用而特别优化和配置的数据中心设计。这类设计通过采用最新的硬件和电力系统来支持AI的高功率和高密度计算需求。例如,它们集成了高效的电力传输、冷却系统和计算密度,能够支持AI训练和推理任务所需的强大计算能力。AI就绪设计通常包括更高的功率密度、先进的冷却技术(如液冷),并针对GPU和AI工作负载进行优化,以实现更高的性能和能效。这样,数据中心能够更好地满足AI应用的性能需求,并降低整体的总拥有成本(TCO)。

Meta原有的“H"型旧设计,对建筑整体建设部署成本较高:通过计算发电机组数量比较会发现,其"H"型建筑最多配备36个发电机组,但Google使用更大容量的发电机仅需34个,而且其单体建筑面积是Google建筑的一倍多。考虑到规模和结构的复杂性,建设周期差异很大:"H"建筑从开工到竣工需要约两年时间,而Google的建筑仅需6-7个月。

然而,以上都不是做出设计改变的根本动因,更重要的是功率密度:Meta原有的“H"型建筑每平方英尺千瓦数不足Google数据中心的1/3,哪怕"H"建筑在能源效率方面具有显著优势,依然无法抵消其在生成式AI竞争中的劣势。因为任何无法提供更高密度液体冷却能力的数据中心,将来都无法为客户带来显著的性能与总拥有成本(TCO)改进,进而导致在生成式AI竞争中落后。

02 算力密度增加带来“新变”

近年来,数据中心的性能演进正逐步适应高功率密度和AI工作负载的需求,但这一过程面临着技术和经济上的多重挑战。

数据中心的性能演进

首先,高功率密度方面,目前大多数现有托管数据中心都还没有准备好支持单机架功率密度超过20 KW的需求。尽管预计2024年芯片供应瓶颈将有所缓解,但对于超大规模企业和托管服务提供商可能仍然会面临数据中心容量的限制,尤其是在人工智能方面相关因素的准备不足。例如,传统托管设施中普遍存在的12-15kW功率限制等,都可能会成为建设AI集群数据中心理想物理密度的障碍。

AI集群数据中心

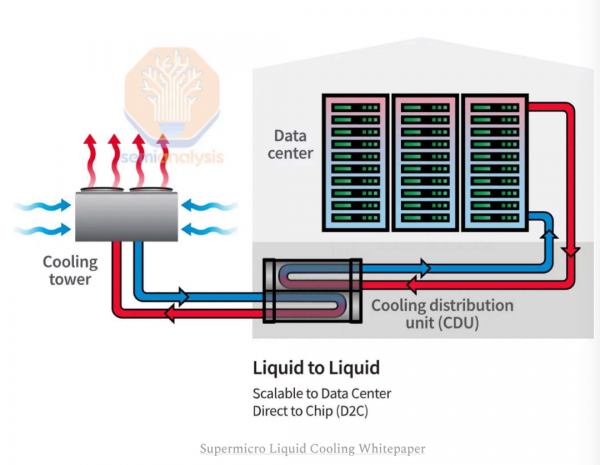

一般来说,在新建数据中心中部署背板式热交换器和液冷方案,可以有效解决功率密度问题。但与采用传统设计方案的已建设数据中心进行改造相比,从头设计融入这些解决方案的新数据中心其实更合理。因为改造现有的数据中心会存在各种各样不可预知的问题。比如,可能缺乏足够的物理空间容纳额外的2-3 MW发电机、不间断电源(UPS)、开关设备或变压器等,而且重新铺设管道以适应液冷所需的冷却分配单元(CDU)等设备在某些情况下难度也会比较大。Meta也正是因为意识到这一点,所以暂停了原有的数据中心项目,转而重新设计专为人工智能工作负载定制的新型数据中心。

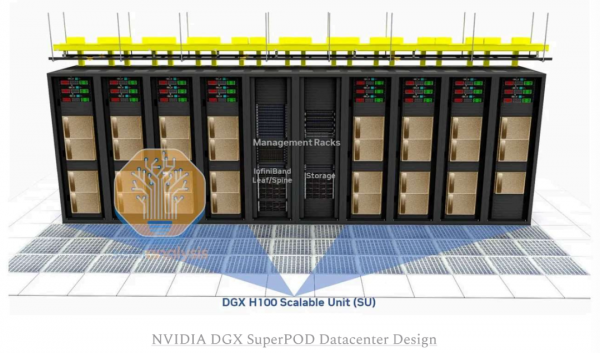

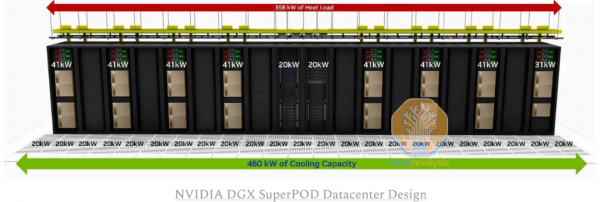

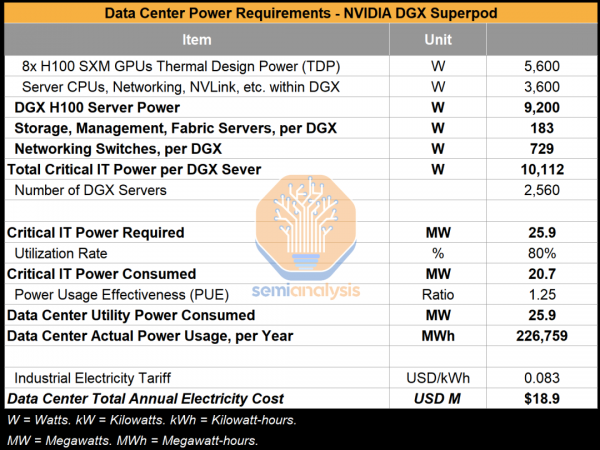

以NVIDIA的DGX H100服务器为例,为了满足高功率密度,其部署方式会受到数据中心的电力和制冷能力限制有所不同,单个机架内可能仅能部署2到3台DGX H100服务器,并将相邻机架留空。

服务器部署方式

此外,随着越来越多的数据中心开始支持人工智能工作负载,通过增加专用气流设备,单个机架的功率密度有望达到30-40 kW,甚至更高,并且仍采用空气冷却的方式。未来采用液冷技术可以减少风扇的用电量,从而降低单机架的能耗约10%,并通过减少或消除对环境空气冷却的依赖,使电力使用效率(PUE)降低0.2-0.3。当然,这对大多数数据中心来说也是最后一波显著的PUE优化空间。

数据中心空气冷却方式

更值得关注的是,AI训练和推理对数据中心的工作负载有着独特的要求,这与现有数据中心中部署的典型硬件有很大不同。

AI训练工作负载非常耗电,AI硬件的运行功率通常接近其热设计功率(TDP),每台AI服务器现在都超过了10KW。再考虑到AI训练对延迟不敏感,以及对靠近人口中心重要性的降低,这意味着与传统工作负载相比,对于AI训练来说,大量廉价电力的可用性(未来获得任何电网供应的可能性)对于工作负载而言具有更高的相对重要性。而对于AI推理来说,最终将会产生比训练更大的工作负载,总体规模将是巨大的,但不同于训练,推理可以是相当分布式的,芯片并不需要集中放置。

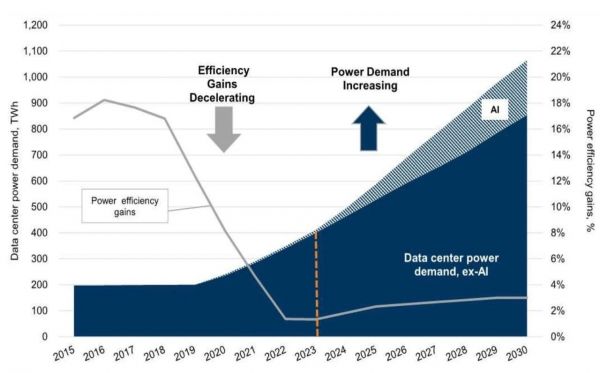

03 电力需求提升引发“新变”

AI训练和推理的巨大需求正在成为数据中心规划建设诸多变化的主要驱动力,使得电力供应紧张加剧,更重要的是电力需求提升将正在导致电力或冷却系统问题频发,进而持续影响着整个产业格局。

AI训练和推理

电力需求有多大?

一个包含20,840个Nvidia H100集群的数据中心需要约25.9MW的核心IT功率容量。而目前,整个数据中心行业正在建设容量更高的100,000个H100集群和千兆瓦级(Gigawatt)集群,数据中心基础设施的供电能力需求还将继续飙升。

数据中心基础设施的供电能力需求

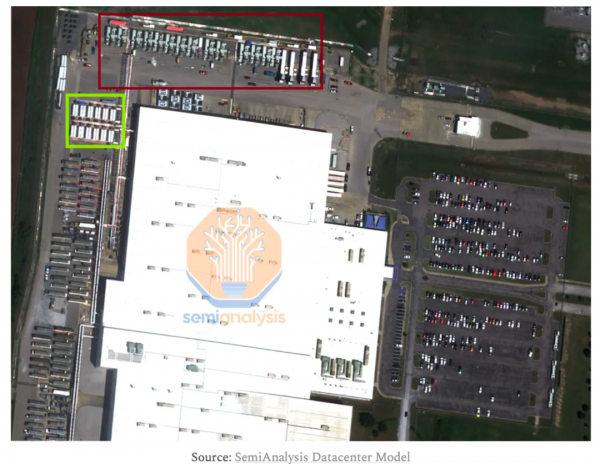

Source:SemiAnalysis Datacenter Model

数据中心的电力挑战

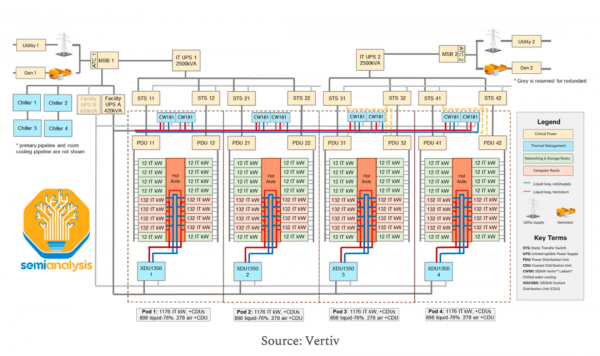

以Nvidia为例,其GB200系列的高功率需求(每个机架超过130kW)与以往的数据中心设计截然不同,这也就导致当前新建数据中心(智算中心)在电力系统方面要格外重视。

未来,任何数据中心的电力或冷却系统问题都可能导致运营中断,进而带来巨大的收入损失和声誉损害。这对于云服务提供商(CSP,如Azure和AWS)以及托管服务提供商(如托管数据中心房地产)尤为重要。确保高正常运行时间(Uptime)是确保收入的关键,这很大程度上依赖于电力与冷却系统的可靠性。尽管电气故障相对更常见,但通常其影响范围较小,而冷却系统故障的破坏性往往更大。

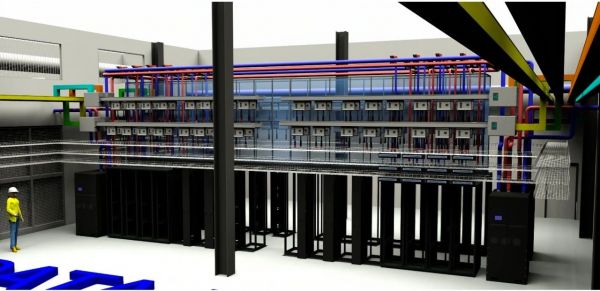

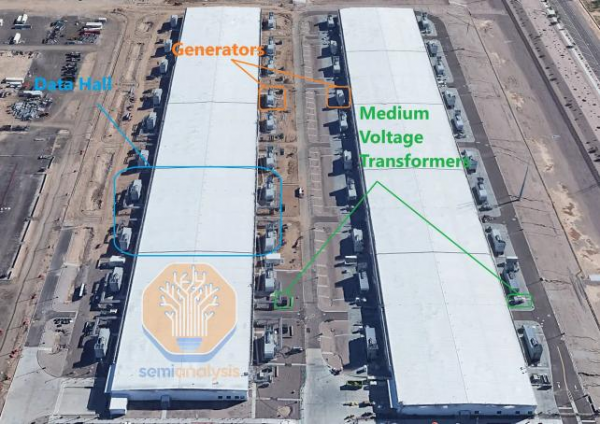

从数据中心和电力流角度来看,现代数据中心正在通过模块化方式构建,一座数据中心通常被分解为多个机房(Data Halls,蓝色矩形),每栋数据中心建筑(约25万平方英尺)的关键IT容量(Critical IT capacity)为48MW,每栋建筑分为五个机房,即每个机房9.6MW。

数据中心模块化方式构建

Source:Google Earth,SemiAnalysis

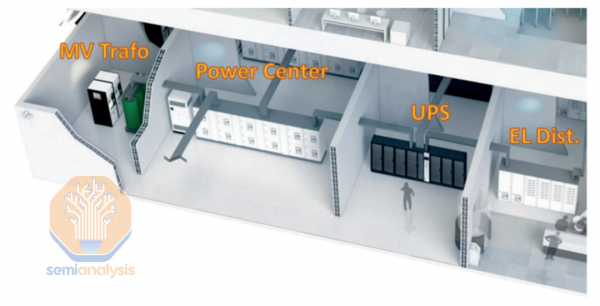

在一个机房内有多个"Pod",每个Pod都有自己专用的一组电气设备:发电机(Generator,橙色矩形)、变压器(Transformer,绿色矩形)、不间断电源(UPS)和开关设备(Switchgear)。在上图中,可以看到每个机房有四个发电机和变压器。还有四个Pod,这也意味着四个低压配电板(Switchboards)和八个UPS系统(假设2N配电冗余)。

机房发电机

Source:Legrand

机房通常划分为Pod以实现模块化和标准化的设计,主要有以下两个原因:

1.模块化:设施可以根据负载需求逐步扩展,以实现快速适应高负载的能力。

2.标准化:Pod的设计使其与标准化的电气设备相匹配,这些设备在市场上更易于采购且成本较低,避免了订制设备的高昂价格。

以Nvidia的下一代Blackwell数据中心设计为例,在新的架构中,一个通道甚至一整排机架都将作为机房中的新“Pod”。

数据中心设计

而在电力传输架构中,每个机架需要两个(NVL36)或四个(NVL72)33kW电源架,考虑到空间和密度限制,不太可能使用机架内BBU(Battery Backup Unit,电池备份单元),这意味着中央UPS依然是必需的。

中央UPS

因此,电力需求的大幅增长将导致供应商的供货量显著提升,这很可能进一步加剧供应链紧张。

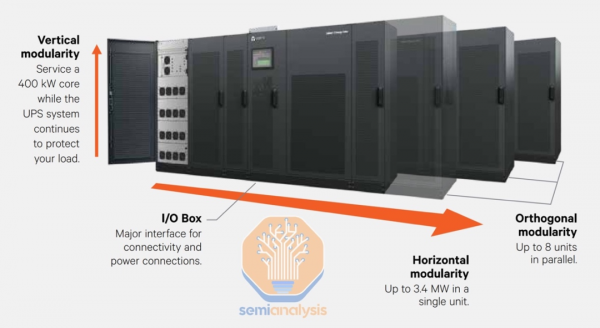

模块化UPS

传统UPS是数据中心用电效率"杀手",导致数据中心PUE居高不下。而现代UPS系统大多采用模块化设计:不再使用单一的大型设备,而是将其拆分为若干可堆叠、并联工作的小型"电力模块"。以Vertiv最新产品为例,单个电力模块的容量为200kVA或400kVA,模块化UPS产品可在单机柜内集成多达10个电力模块,多机柜并联可进一步扩容,单系统最大容量可达27MW。此外,现代模块化UPS采取了多项节能设计。比如Vertiv的产品支持"变频节能模式"(VFD mode),可绕过变流器,将效率提升至99%以上。但这种模式下切换时间可能延长数毫秒,存在瞬时断电风险。

模块化UPS

Source:Vertiv

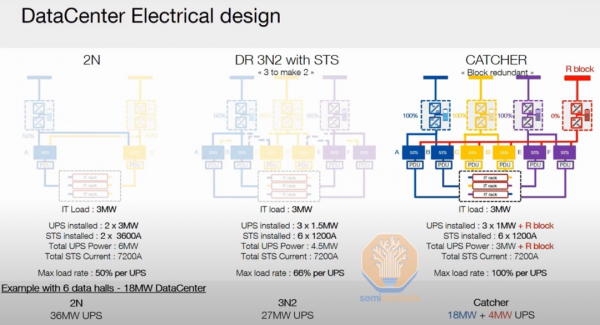

此外,超大规模数据中心通常采用4N3R(四套可用设备对应正常运行所需的三套)或N+2C(也称为"Catcher")等方案,以提高UPS负载利用率(更高效),并降低每兆瓦的资本支出(CapEx)。

在Catcher方案中,没有配置两个满载能力的UPS系统(如下例中的2*3MW),而是采用N+1设计,包含多个较小的UPS(3*1MW)和一个冗余单元。当出现故障时,我们使用静态转换开关(Static Transfer Switches,STS)将负载瞬间从一个UPS切换到另一个。STS比自动转换开关(ATS)快得多,因为它们依靠电力电子元件而非机械部件。在4N3R方案中,我们使用四套独立的配电系统,从配电一直到背板(即从电源线一直到发电机和变压器),其中仅需三套即可保证运行。

Catcher方案

Source:SOCOMEC

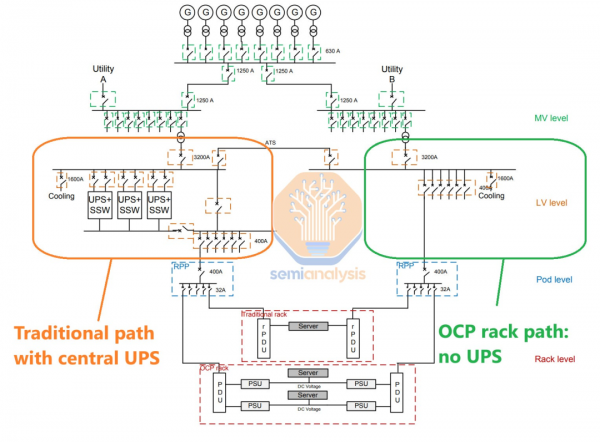

OCP机架与电池备份

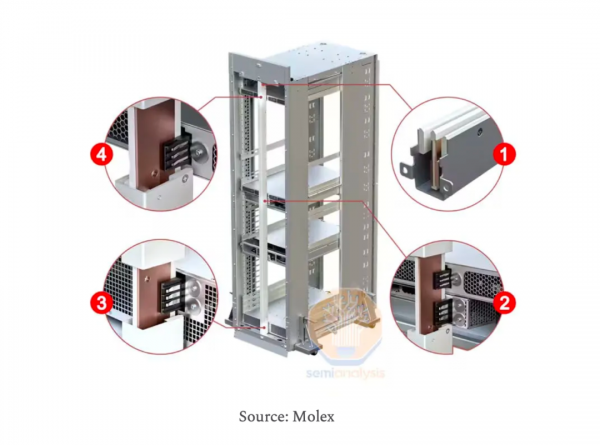

值得关注的是,超大规模企业往往会突破常规,另辟蹊径。比如Meta十年前推出的OCP(Open Compute Project)开放计算机架就是个典型案例。在传统机架设计中,服务器通过配置在机柜内的PDU获得交流市电,再经服务器内置的整流器转换为直流。而OCP的思路是:不如集中配置一个功能强大的电源架(Power Shelf),直接输出直流电,再通过bus bar统一配送到各服务器,从而省去每台服务器配备AC/DC转换器的重复投入。

此外,OCP电源架还可集成BBU,相当于一个"微型UPS",可在市电断供时持续输出直流电几分钟,保障服务器安全关机。由于电源架位于机柜内部,所以BBU的直流电可就近输送给服务器,免去了传统UPS系统中两次AC/DC的转换损耗。而机房由于不再需要集中的A、B双路UPS,所需电池容量也减少了一半。为进一步降低布线损耗,Google在此基础上提出了48V直流供电方案。

当然,在机柜内大规模部署锂电池,对防火、环控等配套设施提出了更高要求。传统UPS电池多集中布置在独立的电池室内,易于统一管理,这一点OCP设计还难以企及。

传统UPS电池布置

Source:Schneider Electric

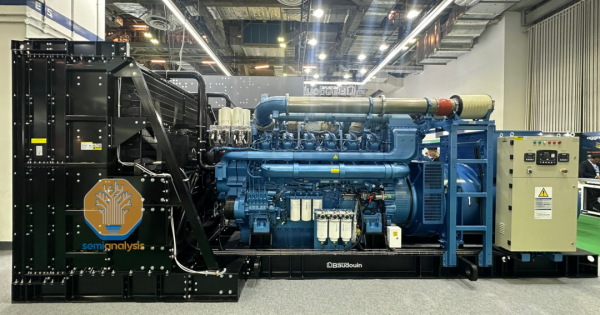

柴油发电机的前景与变化

与此同时,随着AI的快速发展超大规模数据中心正迅速扩展,并努力缩短数据中心的建设周期。柴油发电机也因此面临挑战,尤其是因其噪音和污染物排放而受到的许可限制。

柴油发电机

Source:SemiAnalysis

实时图像分析显示,Meta正考虑完全绕过发电机。而Microsoft的超大型数据中心将只使用部分发电机负载,X.AI在孟菲斯的项目也采用了电池储能系统,发电机作为现场电源的备选,这种变革显示出备用电源正在向更环保的电池储能解决方案转移。

电池储能解决方案

当然,在当前的超大规模数据中心内,发电机依然是不可或缺的选择,在超大规模数据中心内,备用发电机的单机容量一般为2~3MW,园区内动辄部署数十台发电机。当前,这些发电机通常以柴油为燃料,但未来天然气可能会成为主要的替代选择。它们的储油量一般可满足24~48小时的满负荷应急供电。尽管柴油发电的能效更高,但烟气污染也更严重。因此,在环保要求严格的地区,柴油发电机往往配备有尾气处理装置,造价也更高。

最后,还有一个略微产生影响的变化因素是冗余度(Redundancy Level)的降低——超大规模运营商已经开始这样做。在大规模训练过程中,由于GPU节点上的高故障率,训练框架被迫发展出了强大的容错机制,使得现代训练系统具备了较好的抗故障能力(Robustness),这使得数据中心端较低的冗余水平变得越来越可以接受。

总之,当前数据中心建设与AI技术的发展密不可分,尤其对于正处于火热建设中的中国智算中心建设市场来说,快速的市场变化需要强有力的设计和运营合作伙伴,以应对增长的功率密度需求和不断变化的技术趋势。供应商之间的合作将推动更高效、更具扩展性的满足AI的数据中心设计,并在竞争激烈的市场中取得领先地位。

参考资料及文章内容来源:

1.Deploying The AI Factory

2.Datacenter Anatomy Part 1_ Electrical Systems

3.Al Datacenter Energy Dilemma

4.Generational growth Al,data centers and the coming US power demand surge

5.Powering Up Europe:AI datacenters and electrification to drive+c.40%-50%growth in electricity consumption etc.

联系我们

全国服务热线

4006800621

公司:通慧网联(北京)数据科技有限公司

地址:中国北京市西城区马连道路4号院

4006800621

4006800621

首页

首页

产品

产品

案例

案例

联系

联系